Más Información

Fiscalía de Guerrero investiga a alcaldesa de Acapulco por cohecho; indagatoria está relacionada con collar de 227 mil pesos

Tras 17 horas, autoridades venezolanas liberan a periodista mexicano Julián Mazoy; “por ahora estoy bien”, dice

Desfile de embajadores y diplomáticos en Palacio Nacional; Quirino, Tatiana Clouthier, Genaro Lozano y Rutilio, entre ellos

Cuando ChatGPT se hizo público en noviembre del año pasado, tuvo impacto más allá de la industria de la tecnología.

Desde ayudar con la redacción de discursos hasta la codificación de computadoras, de pronto la inteligencia artificial (IA) se perfiló como una herramienta real y útil.

Sin embargo, esto no sería posible sin un hardware informático muy potente.

Y una empresa en particular se convirtió en el centro de la bonanza de la IA: Nvidia, con sede en California.

Originalmente conocida por fabricar el tipo de chips de computadora que procesan gráficos, en particular para juegos de computadora, el hardware de Nvidia es la base de la mayoría de las aplicaciones de IA en la actualidad.

"Es el actor líder en tecnología que permite esta cosa nueva llamada inteligencia artificial", dice Alan Priestley, analista de la industria de semiconductores de Gartner.

"Lo que Nvidia es para la IA es casi como lo que Intel fue para las PC", explica Dan Hutcheson, analista de TechInsights.

ChatGPT fue entrenado con el uso de 10 mil de las unidades de procesamiento de gráficos (GPU) de Nvidia, agrupadas en una supercomputadora que pertenece a Microsoft.

"Es una de las muchas supercomputadoras que se han construido con GPU de Nvidia, para una amplia variedad de usos científicos y de inteligencia artificial", indica Ian Buck, gerente general y vicepresidente de computación acelerada de Nvidia.

Nvidia tiene alrededor del 95% del mercado de GPU para aprendizaje automático, señaló un informe reciente de CB Insights.

Las cifras muestran que su negocio de inteligencia artificial generó alrededor de 15 mil millones de dólares en ingresos el año pasado, 40% más que el año anterior y superó a los juegos como su mayor fuente de ingresos.

Las acciones de Nvidia se dispararon casi un 30% después de que publicara los resultados del primer trimestre el miércoles. La compañía dijo que está aumentando la producción de sus chips para satisfacer la "demanda creciente".

Los chips de IA cuestan 10 mil dólares cada uno aproximadamente, aunque su última y más poderosa versión se vende por mucho más.

¿Cómo se convirtió Nvidia en un actor central en la revolución de la IA?

En definitiva, gracias a la unión entre una apuesta osada y un buen momento.

Una decisión crucial

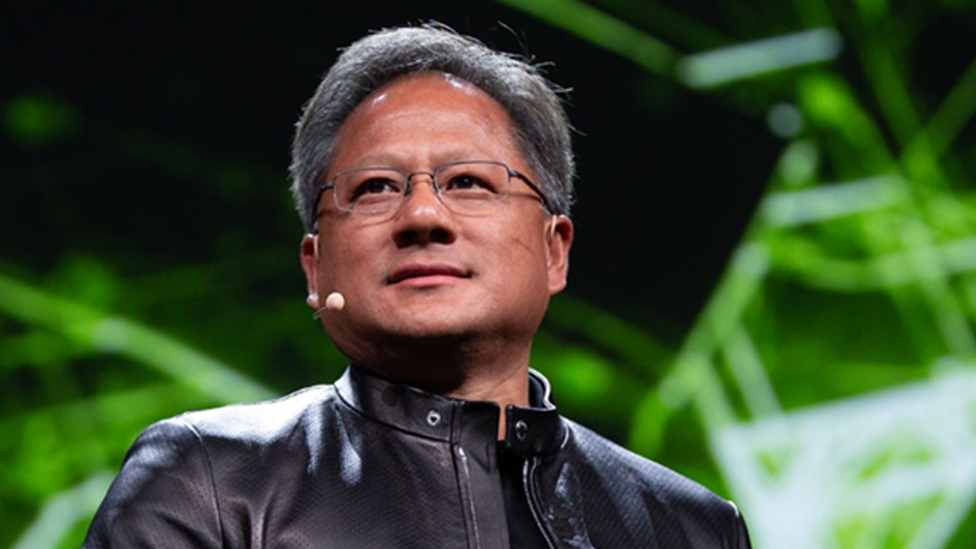

Jensen Huang, ahora director ejecutivo de Nvidia, fue uno de sus fundadores en 1993. Entonces, Nvidia se centró en mejorar los gráficos para juegos y otras aplicaciones.

En 1999, desarrolló GPU para mejorar la visualización de imágenes para computadoras.

Lee también Cuánto le falta a China para superar a EU en el maratón por la Inteligencia Artificial

Las GPU se destacan en el procesamiento de muchas tareas pequeñas simultáneamente (por ejemplo, manejar millones de píxeles en una pantalla), un mecanismo conocido como procesamiento paralelo.

En 2006, investigadores de la Universidad de Stanford descubrieron que las GPU tenían otro uso: podían acelerar las operaciones matemáticas de una manera que los chips de procesamiento normales no podían.

En ese momento, Huang tomó una decisión crucial para el desarrollo de la IA tal como la conocemos.

Invirtió los recursos de Nvidia en la creación de una herramienta para hacer que las GPU fueran programables, abriendo así sus capacidades de procesamiento paralelo para usos más allá de los gráficos.

Esa herramienta se agregó a los chips de computadora de Nvidia. Para los usuarios de juegos de computadora, era una capacidad que no necesitaban y probablemente ni siquiera sabían, pero para los investigadores era una nueva forma de hacer computación de alto rendimiento.

Esa capacidad ayudó a desencadenar los primeros avances en la IA moderna.

En 2012 se presentó Alexnet, una IA que podía clasificar imágenes y se entrenó usando solo dos de las GPU programables de Nvidia.

El proceso de capacitación tomó solo unos pocos días, en lugar de los meses que podría haber tomado con una cantidad mucho mayor de chips de procesamiento regulares.

El descubrimiento de que las GPU podían acelerar masivamente el procesamiento de redes neuronales comenzó a extenderse entre los científicos informáticos, quienes comenzaron a comprarlas para ejecutar este nuevo tipo de trabajo.

"La inteligencia artificial nos encontró", dice Ian Buck, de Nvidia.

La compañía aprovechó su ventaja invirtiendo en el desarrollo de nuevos tipos de GPU más adecuados para la IA, así como más software para facilitar el uso de la tecnología.

Una década, y miles de millones de dólares más tarde, surgió ChatGPT, una IA que puede dar respuestas inquietantemente humanas a las preguntas.

La empresa de inteligencia artificial Metaphysic crea videos de celebridades y otras personas utilizando técnicas de inteligencia artificial. Sus falsificaciones de Tom Cruise crearon revuelo en 2021.

Lee también Apple prohíbe a sus trabajadores usar chatbots de inteligencia artificial como ChatGPT

Para entrenar y luego ejecutar sus modelos, Metaphysic utiliza cientos de GPU Nvidia, algunas compradas a Nvidia y otras a las que se accede a través de un servicio de computación en la nube.

"No hay alternativas a Nvidia para hacer lo que hacemos", afirma Tom Graham, su cofundador y director ejecutivo. "Está muy por delante de la curva".

Sin embargo, aunque el dominio de Nvidia parece asegurado por ahora, el largo plazo es más difícil de predecir. "Nvidia alcanzó el objetivo que todo el mundo está tratando de conseguir", señala Kevin Krewell, otro analista de la industria en TIRIAS Research.

Otras grandes empresas de semiconductores ofrecen cierta competencia. AMD e Intel son más conocidos por fabricar unidades centrales de procesamiento (CPU), pero también fabrican GPU dedicadas para aplicaciones de IA (Intel se unió recientemente a la competencia).

Google tiene sus unidades de procesamiento de tensor (TPU), que se utilizan no solo para los resultados de búsqueda sino también para ciertas tareas de aprendizaje automático, mientras que Amazon tiene un chip personalizado para entrenar modelos de IA.

Por su parte, Microsoft y Meta están desarrollando sus propios chips de IA.

Lee también ¿Lava del volcán Popocatépetl llegaría a CDMX en caso de erupción? IA responde en TikTok

mcc

Noticias según tus intereses

[Publicidad]

[Publicidad]